In [PT92] gibt es eine sehr schöne Tabelle (Tabelle

1), die den Immersionsgrad beschreibt.

| ||||||||||||||||||||||||

| Tabelle 1: Auswirkungen verschiedener Eigenschaften auf die Immersivität | ||||||||||||||||||||||||

Unser ganz besonderer Dank geht an Herrn Andreas Schöbel und die Firma Virtual Reality Technologies, Groß-Umstadt, für die kostenlose Bereitstellung einer SpaceMouse und der VR-Software Superscape Visualizer. Ohne die Unterstützung von VRT wäre unser Vortrag recht trocken gewesen.

Und wir bedanken uns bei den Mitarbeitern des Virtuality Cafés in Berlin, die uns (vor den Öffnungszeiten) unseren ersten Einstieg in den Cyberspace ermöglichten.

Die Adressen der hier aufgeführten Firmen sind im Anhang A zu finden.

virtual reality: 1. Computer simulations that use 3-D graphics and devices such as the DataGlove to allow the user to interact with the simulation. [...]Virtual Reality läßt sich daher wohl besser definieren, wenn wir beschreiben, was VR leisten muß (vgl. [Nur93] und [LA94]):

In [PT92] gibt es eine sehr schöne Tabelle (Tabelle

1), die den Immersionsgrad beschreibt.

| ||||||||||||||||||||||||

| Tabelle 1: Auswirkungen verschiedener Eigenschaften auf die Immersivität | ||||||||||||||||||||||||

Der Begriff Artificial Reality wurde von Myron Krueger definiert und beschreibt ein videobasiertes, interaktives Computersystem [Gig93]. Krueger will eine natürlichere Art der Interaktion mit dem Computer entwickeln, der Benutzer soll nicht in unbequeme Datenhandschuhe und Head-Mounted-Displays gezwungen werden. Sattdessen nimmt eine Videokamera die Umrisse oder Hände auf. Dies wird beispielsweise in Kruegers Projekten VIDEOPLACE und VIDEODESK ausgenutzt [Kru93].

Bei VIDEOPLACE agiert der Umriß des Benutzers (dank

Bildverarbeitungstechniken) mit grafischen Objekten und künstlichen

Lebewesen, den CRITTERS (siehe Abbildung 1).

Im VIDEODESK-System werden die Umrisse der Hände von einer

Kamera oberhalb des Tisches aufgenommen. Die Hände dienen dabei als

Ersatz für die Maus (oder einen Datenhandschuh). Der Vorteil liegt

dabei in der natürlicheren Handhabung, das Erlernen des Umgangs mit

der Maus entfällt und die Beschränkung auf nur einen Punkt

(Mauszeiger) wird ebenfalls aufgehoben. So können zum Beispiel ganz

einfach Splinekurven gezeichnet werden. Die Interaktion erfolgt durch

Gesten (Abbildung 2).

|

| Abbildung 2: Bei VIDEODESK kann auf ganz natürliche Art und Weise eine Splinekurve gezeichnet werden. |

Unter Telepräsenz versteht man das Arbeiten an einem anderen Ort. Gewöhnlich steht an diesem anderen Ort ein Roboter, der mit zwei Kameras versehen ist und so dem Steuernden ein stereoskopisches Bild vermittelt. Mittels Datenhandschuh (oder anderen Eingabegeräten) kann er den Roboter steuern. Die Sensordaten des Roboters (Druck, Temperatur usw.) werden dem Operator für ihn ungefährlich übermittelt.

Eine Variante der Telepräsenz ist die Mixed Reality. Die Umgebung des Roboters wird nicht von Stereokameras erzeugt, sondern kommt als Grafik aus dem Computer.

Bei Augmented Reality (AR) Systemen werden Computergrafiken auf transparenten Displays dargestellt. Auf diese Weise sieht der Träger gleichzeitig die reale Umgebung und die computergenerierte Welt. Angewendet wird dies besonders in der Medizin, z.B. kann ein Chirurg so gleichzeitig seinen Patienten und dessen Computer-Tomograph-Aufnahmen sehen.

Der Begriff Cyberspace tauchte erstmals in dem Roman Neuromancer [Gib87] von William Gibson auf und wird oft falsch eingesetzt, um Virtual Reality zu beschreiben. Tatsächlich ist mit Cyberspace der Gibsonsche Informations-Raum gemeint, den Daten-Cowboys mit sogenannten ,,cyberspace decks`` (eine Art Gehirn-Computer-Interface) besuchen.

,,Kyberspace [sic!]. Unwillkürliche Halluzination, tagtäglich erlebt von Milliarden Berechtigten in allen Ländern, von Kindern zur Veranschaulichung mathematischer Begriffe ... Grafische Wiedergabe abstrahierter Daten aus den Banken sämtlicher Computer im menschlichen System. Unvorstellbare Komplexität. Lichtzeilen in den Nicht-Raum des Verstands gepackt, gruppierte Datenpakete.``Die einzelnen Rechner sind dabei durch die sogenannte Matrix verbunden:

,,Die Matrix ist eine abstrakte Darstellung der Beziehungen zwischen Datensystemen. Legitimierte Programmierer koppeln sich an den Matrixsektor ihres Arbeitgebers an und finden sich wieder inmitten der bunten geometrischen Formen, die die Firmendaten darstellen. [...] Legitimierte Programmierer sehen die Wände aus Eis [= Elektronisches Invasionsabwehr-System] nicht, hinter denen sie arbeiten, die Schattenwände, die ihre Operationen abschirmen vor anderen, vor Industriespionage-Artisten und Gaunern [...].`` [Gib88]Heute ist der Begriff Cyberspace ein richtiges Modewort geworden und wird vielfältig mißbraucht. So wird häufig auch das World Wide Web (WWW) als Cyberspace bezeichnet. Die fehlende Dreidimensionalität und das Immersionsgefühl werden derzeit durch das VRML-Projekt behoben (VRML = Virtual Reality Modeling Language, siehe [Gra95] und [SW95]).

Kleine Anekdote am Rande: AutoDesk wollte den Prototyp ihres VR CAD -Systems unter dem Namen Cyberspace als Handelsmarke registrieren lassen. Daraufhin teilte Gibson der Firma mit, daß er seinerseits prüfe, ob sich der Name Eric Gullichsen als Handelsmarke registrieren lasse. Eric Gullichsen war einer der Entwickler von VR CAD bei AutoDesk.

Die Geschichte der VR ist mal gerade eben 30 Jahre alt. Sie beginnt

bei jemandem, der überhaupt nichts mit Computern zu tun hatte und

auch heute noch nicht hat.

Die Geschichte der VR ist mal gerade eben 30 Jahre alt. Sie beginnt

bei jemandem, der überhaupt nichts mit Computern zu tun hatte und

auch heute noch nicht hat.

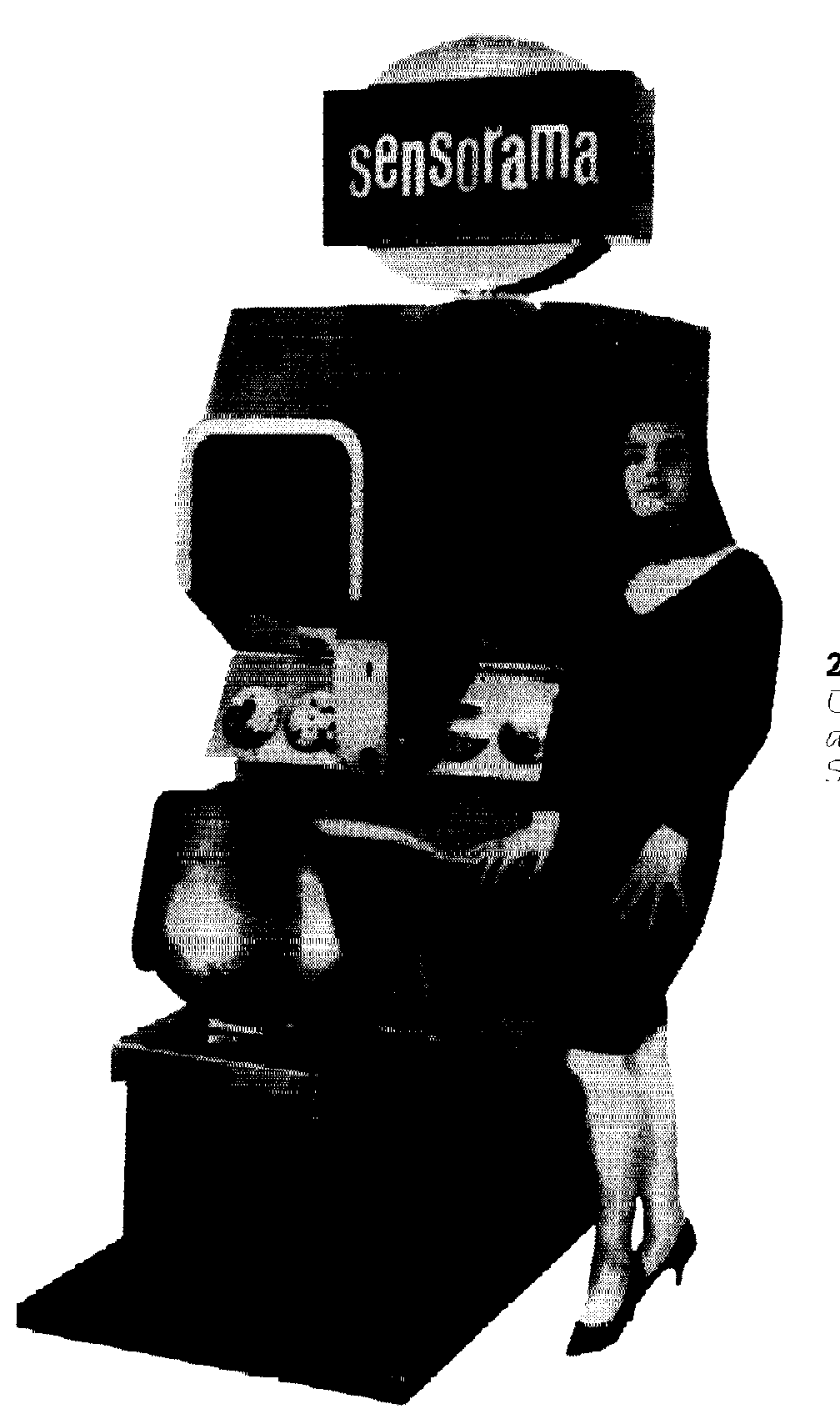

1962 stellte Morton Heilig sein vor (siehe Abbildung 3). Dieser Simulator war für Spielhallen gedacht. Der Besucher sitzt auf einem beweglichen Stuhl und sieht einen stereoskopischen Film einer Motorradfahrt durch New York. Hinzu kommt noch der passende Sound und sogar Geruch und Wind! Damit hatte dieser Simulator alle Komponenten (und sogar noch mehr) heutiger VR-Systeme. Das einzige, was fehlte, war die Interaktivität.

Drei Jahre später veröffentlichte dann der eigentliche Begründer

der virtuellen Realität, der Computergrafik-Pionier Ivan

Sutherland,

seine Vorstellungen des Ultimate Displays

[Sut65]:

,,We live in a physical world whose properties we have to come to know well through long familiarity. We sense an involvement with this physical world which gives us the ability to predict its properties well. For example, we can predict where objects will fall, how well-known shapes look from other angles, and how much force is required to push objects against friction. We lack corresponding familiarity with the forces on charged particles, forces in nonuniform fields, the effects of nonprojective geometric transformations, and high-inertia, low friction motion. A display connected to a digital computer gives us a chance to gain familiarity with concepts not realizable in the physical world. It is a looking glass into a mathematical world. [...]If the task of the display is to serve a looking-glass into the mathematical wonderland constructed in computer memory, it should serve as many senses as possible. [...]

With appropriate programming such a display could literally be the Wonderland into which Alice walked.``

1968 beschrieb er das erste Head-Coupled-Display (HCD) für

eine Augmented-Reality-Anwendung. Bei seinem ,,Sword of Damocles`` (so

benannt, da mehrere Kilogramm Hardware von der Decke auf den Benutzer

herunterhingen), erzeugten zwei seitlich neben den Ohren angebrachte

CRTs die Bilder, die durch halbdurchlässige Spiegel auf das Auge

projeziert wurden. Zu sehen gab es ein Drahtgittermodell eines

Würfels, um den man sich herumbewegen konnte (Abbildung

4).

Sutherland erkannte den Nutzen seiner Technik für das Training von Piloten und gründete 1970 zusammen mit David Evans die Firma Evans and Sutherland, die heute hochwertige Simulatoren konstruiert.

Die Entstehung der Virtual Reality ist sehr eng verbunden mit der Entwicklung von Flugsimulatoren. Der erste Flugsimulator wurde 1929 entwickelt, der sich jedoch auf die Simulation eines reinen Instrumentenflugs beschränkte. Mit der Verfügbarkeit von Videokameras Anfang der 50er änderte sich dies: Der Pilot steuerte mit seiner Flugzeugnachbildung eine Kamera, die über einem Modell eines Flughafens angebracht war. Das Bild der Kamera wurde auf einem Monitor in der Frontscheibe gezeigt.

Mit der Weiterentwicklung der Computer wurden die Pappmaché-Modelle mehr und mehr durch 3D-Objekte aus dem Computer ersetzt. Die Qualität dieser Simulatoren wurde durch die Bildrate (wie schnell kann ein neu berechnetes Bild angezeigt werden; gemessen in fps = frames per second) und den Detailreichtum einer Szene begrenzt. So konnten 1973 bei einem Modell, das aus 200 bis 400 Polygonen bestand, Bildraten von 20 fps erreicht werden (zum Vergleich: Der Detailreichtum des menschlichen Auges beträgt 80 Millionen Polygonen).

1979 experimentierte das Militär mit Head-Mounted-Displays (HMDs). Das Ergebnis war der VITAL Helm, der aufgrund seines Gewichts und der Ungewohntheit durch halbdurchlässige Linsen zu schauen, jedoch wenig Akzeptanz fand.

Etwa zur gleichen Zeit in der Sutherland sein HCD entwickelte,

,,erfand`` Myron Krueger seine Artifical Reality, bei der Teilnehmer

auf natürliche Art und Weise mit vom Computer generierten Objekten

agieren konnte (siehe Seite ![[*]](cross_ref_motif.png) ).

).

Mit der Zeit wurden die Flugzeuge so kompliziert, daß die Piloten nicht mehr oder kaum noch in der Lage waren, alle Fähigkeiten eines Kampfjets zu beherrschen: Eine falsche Bewegung oder Knopfdruck und der Düsenjäger schmierte ab. So wurde 1982 das VCASS-System (Virtually Coupled Airborne Systems Simulator) von Tom Furness vorgestellt. Es bestand aus einem HMD (wegen seines Aussehens auch als ,,Darth Vader``-Helm bezeichnet) und einem 6D2-Positions- und Orientierungs-Tracker. Zu sehen war ein vom Computer generiertes Abbild der Umgebung. Im Display wurden Fluginformationen und wichtige Objekte (Feindflugzeuge, Radaranlagen u.ä.) angezeigt. Dadurch wurde die mentale Belastung des Piloten verringert, da nur noch die wichtigsten Sachen angezeigt wurden. Zudem war es auch egal, ob es gerade bewölkt oder Nacht war: Die virtuelle Landschaft wurde aus Radar- und Satellitendaten generiert. Aus dem VCASS-Projekt entstand später das SuperCockpit-Projekt.

Anfang der 70er beschäftigte sich Frederick Brooks an der University of North Carolina (UNC) mit der Kraftrückkopllung (force feedback) und entwickelte das GROPE II-System. Grundlage war ein Argonne Remote Manipulator (ARM) (von der Industrie benutzt, um z.B. radioaktives Material zu behandeln), der mit zusätzlichen Motoren versehen wurde, um dem Benutzer ein Widerstandsgefühl zu vermitteln. Mit dem GROPE-II-System sollten Moleküle angedockt werden, doch leider war die Computertechnik noch nicht in der Lage, derart komplexe Gebilde zu simulieren. Das System verschwand im Keller und wartete auf seine Wiedererweckung...

Dies geschah 1986 und es wurde das GROPE III-System entwickelt. Jetzt konnte der Chemiker die elektrischen Kräfte der Moleküle fühlen. Das System wurde außerdem um eine LCD-Shutter-Brille ergänzt, um einen dreidimensionalen Eindruck zu erhalten.

An der UNC wurden erstmals auch CAD-Daten interaktiv visualisiert. Auf einem Laufband konnten Besucher durch ein neues Gebäude gehen, das noch gar nicht existierte. So konnten Designfehler behoben werden.

1984 wollte Michael McGreevy auch für das NASA Ames ein VR-System entwickeln. Dazu wurde ihm ein Etat von 10.000 Dollar genehmigt. Bereits im Besitz grundlegender Hardware fehlte ihm eigentlich nur noch ein HMD. Also besuchte er Tom Furness auf der Wright-Patterson Air Force Base, um den Helm aus dem VCASS-System zu erwerben:

,,Kein Problem``, sagte dieser, ,,für eine Million Dollar kannst du's

haben.``.

,,Nein, nein``, antwortete McGreevy, ,,ich will nur den Helm

und nicht das ganze System¡`.

,,Ich meinte auch nur den Helm.``

Frustriert verließ McGreevy den Stützpunkt und kam bei Radio Shack3 vorbei. Im Schaufenster entdeckte er eine Neuheut aus Japan: Den Sony Watchman für $79.95! Sofort kaufte er zwei davon, versah ihn noch mit anderer notwendiger Elektronik und schon war er im Besitz des ersten HMDs auf der Welt, das keine 2000 Dollar kostete. Fertig war sein Virtual Visual Environment Display (VIVED).

1985 stieß Scott Fisher zum NASA VIVED Projekt hinzu und brachte neue Ideen wie den Datenhandschuh, 3D-Sound und Force-Feedback mit ins Spiel.

Der Datenhandschuh wurde übrigens von Thomas Zimmermann erfunden, der damit eigentlich die perfekte Luftgitarre bauen wollte. Er schließ sich später mit Jaron Lanier zusammen (Lanier entwicklte derzeit eine Programmiersprache für Nicht-Programmierer und macht dies auch noch heute) und gründete 1985 VPL Research, dessen erstes Produkt der berühmte DataGlove war.

Seit den Entwicklungen von McGreevy und Fisher ist VR-Technik so günstig geworden, daß nicht nur das Militär die nötigen Geldmittel hat.

Zu den notwendigen Eingabegeräten gehört der Datenhandschuh und ein Trackingsystem (ein Sensor/Empfänger auf dem HMD und Handschuh; ein oder mehrere Sender fest im Raum installiert). Zu den Ausgabegeräten gehören als Minimalausstattung nur die Bildschirme des HMD.

Dieses System kann um die folgenden Geräte ergänzt werden:

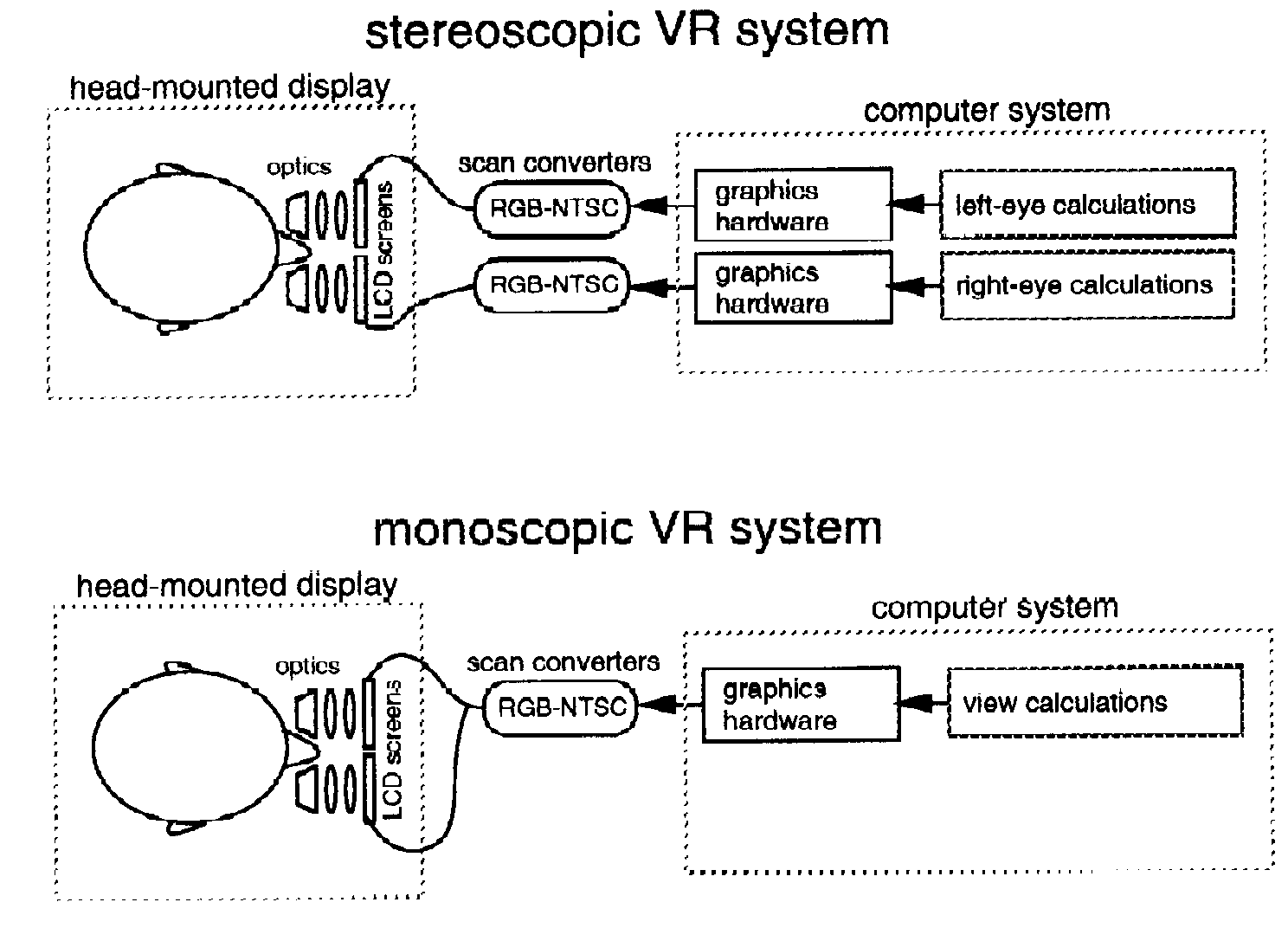

Die meisten Bildschirme in den HMDs erwarten die Signale in der amerikanischen NTSC-Fernsehnorm, Grafikkarten der PCs und Workstations kreieren aber überwiegend RGB-Signale (RGB = rot, grün, blau). Daher muß ein RGB-NTSC-Konverter zwischengeschaltet werden. Hauptaufgabe dieses Scan-Konverters ist es, das non-interlaced Signal der Grafikkarte in ein interlaced Signal zu transferieren.4 Leider können diese Konverter zum Teil so teuer werden wie die gesamte Workstation alleine.

Viele VR-Systeme arbeiten mit zwei Reality Engines, wobei jede Maschine einem Auge zugeteilt wird. In diesem Fall spielt die Synchronisation der beiden Rechner eine große Rolle.5

Soll die virtuelle Welt noch um eine 3D-Geräuschkulisse ergänzt werden, so muß der 3D-Sound-Prozessor die Geräuschquellen vor der Ausgabe noch verarbeiten. Der Ton muß zudem synchron zum Bild geliefert werden (die zwei Bilder bei stereoskopischen Systemen übrigens auch -- eine gar nicht so leichte Aufgabe!).

Die Kommunikation mit den Eingabegeräten (Datenhandschuh, Tracker) erfolgt über die Ein- und Ausgabeschnittstellen, wobei die Daten zum Teil schon vorverarbeitet werden (z.B. wandelt eine Elektronik im Datenhandschuh die Fingerkrümmung in binäre Werte um).

Die Software muß in Echtzeit die Szenen berechnen und darstellen können. Professionelle Systeme ,,verpulvern`` die Rechenzeit in Detaildarstellung, wenn sich der Benutzer nicht bewegt. Verändert er seine Position wird dagegen mehr Wert auf einen flüssigen Ablauf gelegt und weniger Details berechnet, damit die Latenzzeit so gering wie möglich ist.

Außerdem müssen die gelieferten Positionsdaten verarbeitet werden, z.B. um festzustellen ob der Teilnehmer mit einer Wand kollidiert ist. Bei Mehrbenutzer-VR-Systemen steigt dieser Verwaltungsaufwand rapide an. Zudem muß für jeden Teilnehmer sein eigenes Sichtfeld berechnet und dargestellt werden und der oder die anderen irgendwie in die Szene eingesetzt werden.

In Japan wird diese Methode sogar schon in der Wirtschaft eingesetzt: Die Kunden eines Kücheneinrichters müssen die Maße ihrer Küche angeben und können sie dann nach Herzenslust in der virtuellen Welt einrichten. So werden Enttäuschungen vermieden, wenn die Möbel nicht passen oder die Komponenten zusammen unschön aussehen.

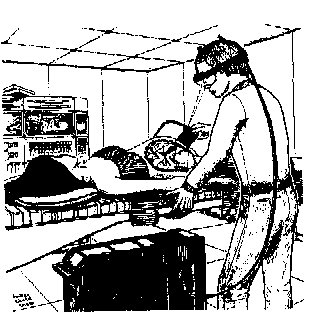

|

| Abbildung 6: Bei dieser Augmented-Reality-Anwendung sieht der Arzt sowohl seine Patienten als auch die Ultraschallaufnahmen des noch ungeborenen Kindes. |

Außerdem kommen VR-Systeme bei Operations-Vorbereitungen oder bei der Ausbildung zum Einsatz; die Medizinstudenten können auf diese Weise realitätsnäher ausgebildet werden, als wenn sie z.B. an Gummipuppen üben müssen.

Die VR-Forscher und Mediziner können sich auch Remote-Operationen vorstellen, bei denen sich der oder die Spezialisten mittels VR-Techniken bei komplizierten Operationen einklinken. Derartige Systeme würden sich auch in Gebieten eignen, deren Ärztedichte sehr gering ist (oder auch um Verwundete an Frontlinien zu behandeln).

Mit Hilfe von VR werden heute auch schon Phobien untersucht. So beschäftigt sich eine Gruppe am GVU (Graphic, Visualization and Usability Center) des Georgia Institute of Technology derzeit mit der Höhenangst. Die Personen betreten einen virtuellen Fahrstuhl und fahren in den 50. Stock; selbst bei einer sehr geringen Bildschirmauflösung werden noch die typischen Symptome der Höhenangst festgestellt ([Hod95] und [Ber95]).

Ein Problem für die VR in der Medizin stellt die lange Entwicklungszeit dar, denn es müssen langwierige Testphasen durchlaufen werden (bis zu zehn Jahre), um mögliche Fehler zu vermeiden. Besonders in den USA ist in den letzten Jahren die Angst vor möglichen Schadensersatzklagen von Patienten gestiegen und so ist besondere Vorsicht bei neuen ,,Wundertechnologien`` angebracht.

Es gibt bereits Konferenzen, die sich ausschließlich dem Thema VR in der Medizin widmen (z.B. ,,CVRMed '95`` [Aya95] und ,,Medicine Meets Virtual Reality III`` [Sat95])

Mittels Virtual Reality kann man sich auf Atomgröße schrumpfen lassen (Die ,,Phantastische Reise`` läßt grüßen) und neue Moleküle zusammensetzen (z.B. mit dem GROPE-III-System an der University of North Carolina, wo mit Force-Feedback und VR-Technik schon neue Enzyme für die Medizin entwickelt wurden).

Eine andere Idee ist es, Aktien an der Wertpapierbörse durch ein Weizenfeld darzustellen. Steigt der Kurs einer Aktie, reift die Pflanze heran, fällt er, verfault sie. Mittels VR kann man nun über das Feld fliegen und die geeignete Aktie ,,ernten``.

Der Telepräsenz kommt gerade bei der NASA eine große Aufmerksamkeit zu Gute, da nur durch diese Technik der Bau von Raumstationen kostengünstig möglich sein wird. Aufgrund der langen Übertragungszeiten sind jedoch keine Echtzeitanwendungen möglich, so daß ein ganzer Arbeitsablauf vorher auf der Erde festgelegt wird und dann komplett übertragen wird.

Aber auch hier bei uns in Deutschland wird fleißig in Sachen Raumfahrt und Telepräsenz geforscht. Das ROTEX-Projekt (Space Robot Technology Experiment) der DLR (Deutsche Luft- und Raumfahrtgesellschaft) benutzt beispielsweise LCD-Shutter-Brillen mit stereoskopischen 3D-Grafiken auf Silicon Graphics Workstations [Spe94].

Cybersex und Hochzeiten6 im Cyberspace sind aber keine Phantasien mehr, sondern schon Wirklichkeit [Rhe95], [3SA95].

Damit wären die ,,technischen Details`` der Datenaufnahme abgehandelt. Viel wichtiger ist aber das, was die ,,Software``, unser Gehirn, leistet, um aus den rohen Daten Informationen zu generieren. Eine wichtige Frage ist, wie wir Tiefe wahrnehmen. Obwohl der Mensch (wie die meisten anderen Lebewesen auch) über zwei Augen verfügt, können wir bereits mit nur einem Auge Tiefe wahrnehmen. Dies ist dank vieler Hinweise möglich (es sei noch erwähnt, daß es für unser Auge/Gehirn überhaupt keine kognitive Arbeit kostet, aus den Pixelinformationen Form, Farbe etc., also die visuellen Merkmale, zu extrahieren):

Durch die Kombination dieser visuellen Hinweise können wir also auch nur mit einem Auge Tiefe empfinden. Allerdings sind hier Fehler nicht ausgeschlossen. Dies ist erst durch das binokulare (stereoskopische) Sehen möglich. Dadurch, daß unsere Augen etwa 6,5 cm auseinanderliegen, nimmt jedes Auge ein etwas anderes Bild wahr. Aus diesen beiden kann das Gehirn sofort die Tiefe ermitteln. Genau auf dieser Fähigkeit beruhen die bekannten Magic Eye-Bilder7. Zum stereoskopischen Sehen sind 95% der Menschheit befähigt, bei den verbleibenden 5% ist die Ursache im Astigmatismus8 zu finden.

Damit haben wir nun die Faktoren, die ein VR-Display bestimmen, aufgezeigt. Von der technischen Seite her lassen sich die Displays wie folgt kategorisieren (vgl. [Ute95]):

Die Shutter-Brillen bestehen aus transparenten LC-Display s und werden per Infrarot-Signal ferngesteuert. Dadurch hängt der Benutzer nicht an lästigen Kabeln und hat mehr Bewegungsfreiheit. Zudem kann er immer noch die tatsächliche Umgebung sehen und wird nicht, wie bei den Head-Mounted-Displays, völlig von der Außenwelt abgeschnitten. Meist verfügen die Brillen noch über einen Tracking-Sensor, der dem Rechner mitteilt, wohin der Benutzer seinen Kopf gerade gedreht hat.

Ein erfolgreiches Anwendungsbeispiel von Projektoren und Shutter-Brillen ist die CAVE der University of Illinois (CAVE = CAVE Automatic Virtual Environment) [DSC93]. Die ,,Höhle`` besteht aus drei Wänden à Metern. Die Rückwand und die Decke fehlen. Vier Projektoren stellen die virtuellen Welten dar (für jede Wand einen Projektor, der vierte projeziert auf den Fußboden). Der Höhlenbesucher trägt eine Shutter-Brille inkl. Tracking-Sensor und in der Hand ein Eingabegerät (ebenfalls mit Tracking-Sensor), mit dessen Hilfe er Objekte manipulieren oder Menüs aufrufen kann. Die Bilder werden 60mal pro Sekunde und Auge dargestellt (d.h. die Bildwiederholrate beträgt 120 Hz).

Um das Raumgefühl zu erhöhen, sorgen acht in den Ecken angebrachte Lautsprecher für den richtigen 3D-Sound.

Der Vorteil dieses Systems ist, daß sich bis zu zehn Personen gleichzeitig in der CAVE befinden können. Außerdem entfallen dadurch lästige Berechnungen, die nötig wären, um ein Abbild eines jeden Besuchers darzustellen, wenn HMDs zum Einsatz gekommen wären.

Obwohl unter den nicht-immersiven Systemen aufgeführt, bietet die CAVE ein besseres Immersionsgefühl als HMD-basierte Systeme.

Der Arm ist frei beweglich und mit Tracking-Sensoren bestückt, um den richtigen Ausschnitt aus der virtuellen Welt zu erzeugen.

Die HMDs verwenden entweder Kathodenstrahlröhren (sind also typische Monitore -- nur sehr viel kleiner), auch CRT s genannt (CRT = Cathode Ray Tube ), oder Flüssigkeitskristall-Displays (LCD = Liquid Crystal Display ). Die CRTs haben gewöhnlich eine bessere Bildschärfe, mehr Kontrast und eine höhere Auflösung als die LCDs. Dafür sind sie aber auch teurer und schwerer. Nicht zu vergessen ist die Strahlenbelastung (siehe auch Abschnitt 8).

Durch eine spezielle Weitwinkeloptik wird ein Blickfeld von mehr als 90 Grad erreicht. Alle HMDs haben einen Positionssensor, um die Kopfposition zu ermitteln. Viele verfügen auch über 3D-Audioausgabe.

Nachteilig wirkt sich vor allem das Gewicht dieser Geräte von zum Teil mehr als 2 kg aus. Durch die Kabel zur Kontrolleinheit wird zudem auch noch die Bewegungsfreiheit eingeschränkt. Und dann ist da noch der Preis: Von Karstadts CyberMaxx für 2000 DM bis hin zum FOHMD der NASA für 500.000 DM ist alles dabei.

Am HITL (Human Interface Technology Laboratory) der University of Washington, Seattle, wird derzeit die nächste Generation der VR-Displays entwickelt. Sogenannte Virtual Retina Displays (VRDs) werden durch ihr leichteres Gewicht und höherer Auflösung die herkömmlichen CRTs und LCDs ersetzen. Ein modulierter Lichtstrahl scannt dabei das Bild Pixel für Pixel direkt auf die Netzhaut. Die neuesten Prototypen (unter anderem auch auf der VR World '95 Ende Februar in Stuttgart gezeigt) erreichen schon jetzt VGA-Auflösung (640x525 Pixel) in Farbe bei einem Blickfeld von 40 Grad [Spe95].

Schauen wir uns nun als Beispiel die Optik eines HMDs der NASA Ames

etwas genauer an (siehe Abbildung 11).

Die LC-Displays sind etwa fünf bis sieben Zentimeter vom Auge entfernt angebracht. Durch die vorgelagerten Linsen werden die Bilder der beiden Displays auf ein größeres Blickfeld gebracht und das Fokussieren vereinfacht (siehe unten).

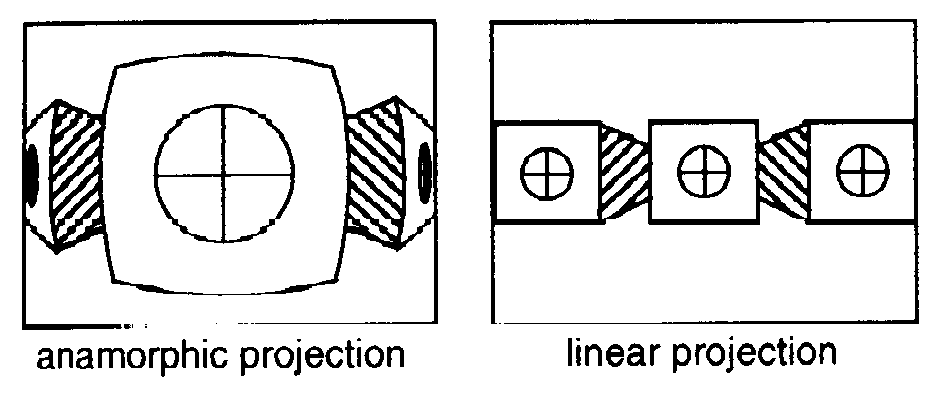

Die von der NASA verwendete LEEP9-Optik erzeugt eine anamorphische Darstellung. Bei diesem, aus der Kinotechnik bekannten, Verfahren10 können Objekte im Vordergrund sehr viel detailreicher dargestellt werden und bei weiter entfernten auf Details bei der Darstellung verzichtet werden (siehe Abbildung 12).

|

| Abbildung 12: Das linke Bild zeigt eine anamorphische Darstellung der gleichen Szene des rechten, linear dargestellten, Bildes. |

Bei der anamorphischen Darstellung zieht der Vorteil der detailreicheren Darstellung im Vordergrund leider einen Nachteil mit sich: Parallele Linien werden gekrümmt. Dieser ,,Nadelkissen-Effekt`` (pincushion effect) muß von der Darstellungssoftware ausgeglichen werden, was wiederum mehr Rechenzeit bedeutet.

Es wurde in Abschnitt 2.1 schon erwähnt, daß die Augen beim Durchschnittsmenschen etwa 6,5 cm auseinaderliegen. Natürlich hat jeder Mensch einen etwas anderen Augenabstand (interpupillary distance = IPD), so daß die Bildschirme für jeden Benutzer eigentlich neu justiert werden müßten, um das Bild richtig zu fokussieren. Liefert die Optik jedoch einen großen Pupillenausgangsdurchmesser, so kann dieser Vorgang entfallen.

Ein zweites Problem ist der Achsenabstand der Optik. Er wird für gewöhnlich so gewählt, daß er der durchschnittlichen IPD entspricht. Dies bedeutet jedoch, daß einige Benutzer nach außen schielen müssen (wie bei den ,,Magic Eye``-Bildern), damit sich die beiden Bilder zu einem neuen, dritten vereinigen. Dies ist jedoch meist schwieriger als die Blickachsen zu kreuzen. Letzteres kann aber dadurch erreicht werden, indem man einen etwas kleineren Abstand wählt.

Oft ist es jedoch aus Platzgründen nicht möglich die Optik so zu plazieren. Der Achsenabstand ist dann meist größer als eigentlich gewünscht. Dies kann einerseits durch sogenannte ,,fresnel prims``, die die Bilder zusammenschieben, oder andererseits durch die Darstellungs-Software ausgeglichen werden. Bei der Software-Variante wird einfach das gesamte Bild auf dem Bildschirm verschoben.

In den früheren LCD-HMDs kamen hauptsächlich die Displays aus den Sony Watchmans zum Einsatz. Inzwischen gibt es aber schon diverse Eigenentwicklungen. LCDs sind sehr viel billiger als Kathodenstrahl-Bildschirme, jedoch haben sie ein paar unschöne Nachteile.

Zum einen ist die Auflösung sehr viel geringer als bei CRTs. Dies wird besonders dann zu einem Problem, wenn es auf eine detailreiche Darstellung ankommt. Zum anderen sind aber gerade deshalb auch die einzelnen Pixelelemente deutlich sichtbar. Zwischen den Pixelelementen befindet sich, technisch bedingt, ein kleiner Abstand. Leider hat aber unser Auge eine Vorliebe für Ecken und scharfe Grenzen, so daß sich die virtuelle Welt hinter einem Maschenzaun präsentiert (siehe Abbildung 13).

|

|

| Abbildung 13:

Links eine virtuelle Szene wie sie auf

einem Computer-Monitor zu sehen ist. Das rechte Bild soll den

Mascheneffekt verdeutlichen, wie er bei LC-Displays auftritt. Die hier dargestellte Szene stammt übrigens aus dem Fahrstuhl-Experiment des Phobia-Projektes am GVU. (Hinweis: Das rechte Bild liegt leider nur noch in der "Papier"-Version vor.) | |

Dieser Effekt kann dadurch gemindert werden, daß direkt vor den LC-Displays ein Pixel-Diffuser angebracht wird, der das ganze leicht unscharf macht. VPL hat zudem noch ein feines, zufälliges Punktmuster auf diesen Diffuser aufgebracht, um dem Auge eine höhere Auflösung vorzugaukeln.

CRTs haben gegenüber den LCDs den Vorteil der höheren Auflösung, besseren Bildschärfe und des Bildkontrastes. Daher eignen sie sich insbesondere für Head-Up-Displays (HUDs), d.h. Datenhelmen bei denen sowohl die virtuelle als auch die reale Welt betrachtet werden kann (Augmented Reality). Abbildung 14 zeigt ein solches Head-Up-Display.

Die meisten CRTs liefern jedoch nur ein Schwarzweiß-Bild. Eine Möglichkeit Farbe ins Spiel zu bringen ist es, LCD-Farbfilter zwischenzuschalten. Ein Bild setzt sich dann aus den drei Grundfarben Rot, Grün und Blau zusammen: Das CRT liefert die Helligkeitsinformation der einzelnen Farben, der LCD-Filter die Farbe selber. Es versteht sich von selbst, daß ein einfaches monochromes Bild nun mit der dreifachen Bildfrequenz dargestellt werden muß (z.B. statt 60 Mhz nun 180 Mhz); spezielle und teure Hochgeschwindigkeits-Elektronik ist vonnöten.

Ein anderes Problem, das bedacht werden muß ist, daß durch die CRTs mehrere tausend Volt neben den Ohren brutzeln.

Eine Letzte, etwas extravagante Variante der HMDs ist die Verwendung von Glasfaserkabeln. Hier werden die Vorteile der LCDs und CRTs vereinigt. Allerdings ist es äußerst kompliziert, die richtige Anordnung der einzelnen Fasern zu einem ,,Bildschirm`` zu gewährleisten. Dies macht das Ganze gar fürchterlich teuer.

Zum Abschluß dieses Abschnitts gehen wir noch auf den Unterschied zwischen monoskopischen und stereoskopischen VR-Systemen ein. Abbildung 15 macht dies schon deutlich.

|

| Abbildung 15: Die obere Skizze zeigt den Aufbau eines stereoskopischen VR-Systems, unten ein monoskopisches. |

Bei stereoskopischen VR-Systemen wird eine virtuelle Szene für jedes Auge getrennt berechnet, bei monoskopischen jedoch nur ein einziges Bild, das beiden Augen zugeführt wird. In Abschnitt 2.1 haben wir gesehen, daß wir auch mit nur einem Auge Tiefe wahrnehmen können. Monoskopische Systeme machen sich aber auch noch das Engagement zunutze. Je mehr der Teilnehmer an der virtuellen Welt interessiert ist, desto mehr fühlt er sich auch in sie hineinversetzt. Genau aus diesem Grund sind alle Spielhallen-VR-Systeme monoskopisch -- und sie sind genau deshalb auch sehr viel günstiger, da nur ein Bild berechnet werden muß und auch die Synchronisation entfällt.

Grundlage für dieses räumliche Hören ist das binaurale (beidohriges) Hören. Dies sagt eigentlich nichts weiter aus, als daß ein Ohr weiter von der Schallquelle entfernt ist als das andere und der Schall somit in einem Ohr schneller ankommt. So ist unser Gehör sogar in der Lage im Vergleich einen Unterschied von nur einem dB auszumachen. Zum Vergleich: Leises Sprechen hat einen Wert von etwa 30 dB.

In einem VR-System werden die Ohren durch die Kopfhörer unabhängig voneinander akustisch gereizt. So führt schon das frühere Eintreffen des Schalls auf dem einen Ohr zu einem Raumeindruck. Dies allein reicht allerdings nicht aus, um festzustellen, ob das Geräusch von vorn oder hinten bzw. oben oder unten gekommen ist. Hierfür ist in entscheidendem Maße die Ohrmuschel verantwortlich, die ein Schallsignal jedesmal anders verzerrt, in Abhängigkeit vom Ort der Schallquelle. Und hierin liegt nun die Schwäche herkömmlicher Kopfhörer: Sie berücksichtigen die individuellen Ohrmuschelformen nicht. Um dem Abhilfe zu schaffen, wird überlegt, eine Art Paß einzuführen, in den die Maße, die in einer einmaligen Vermessung festgestellt werden, eingetragen werden. Sitzt der Benutzer dann an einem VR-System, so wird zunächst nach den persönlichen Parametern gefragt und danach paßt sich das System dann dem Benutzer individuell an.

Der VPL DataGlove (Abbildung 17) ist der am weitesten verbreitete Handschuh. Er ist sehr leicht und bequem zu tragen, da er aus Nylon hergestellt wird. Als visuelles Feedback wird eine virtuelle Hand simuliert, die man im Display sehen kann, sobald sich der DataGlove im Gesichtsfeld befindet. Es werden zwei Sensortypen verwendet: Zum einen Flex Sensoren, die auf der Glasfaseroptik basieren, um die Fingerbeugung festzustellen und zum anderen den Polhemus 3Space Isotrak, um die absolute Handposition bzw. -orientierung im Raum festzustellen (vgl. Abschnitt 6). Mit diesen beiden Komponenten ist es möglich, Handgesten für die Interaktion mit Graphikbildern oder Robotern zu duplizieren.

Der Polhemus 3Space Isotrak ist ein elektromagnetischer Sensor, der zur Bestimmung der absoluten Position verwendet wird. Er erlaubt es, bis zu sechzigmal pro Sekunde die X-, Y- und Z-Koordinaten mit einer Genauigkeit von 3,3 Millimetern sowie Dreh-, Neigungs- und Kippwinkel mit einer Genauigkeit von 0,8 Grad (insgesamt sechs Freiheitsgrade) zu ermitteln.

Dies wird allerdings mit einer hohen Störanfälligkeit bezahlt und genaue Werte werden auch nur geliefert, wenn die Entfernung zwischen Sensor und Source (Quelle) zwischen vier und 28 Zoll beträgt. Die Übertragung in den Computer erfolgt über eine serielle Schnittstelle.

Die Koordinaten werden folgendermaßen interpretiert (vgl. Abbildung 18):

Um die Genauigkeit der Aufzeichnung zu unterstützen, wird vor der Benutzung des DataGloves die jeweilige Hand formatiert bzw. kalibriert. Die Kalibration geschieht in einem einfachen, dreistufigen Verfahren anhand einer Kalibrations-Software. Die Hand muß dabei drei verschiedene Stellungen einnehmen. Einmal formatiert, speichert der DataGlove die Daten im sog. ,,Calibration Table``, um den Hostrechner nicht zusätzlich zu belasten. Der DataGlove kann fortan diese Handgesten erkennen und schickt die Aufzeichnungen weiter an den Hostrechner.

Das DataGlove-System besteht aus zwei Grundkomponenten: Dem DataGlove selbst und der Kontrolleinheit. Ihre Hauptaufgabe ist die Konvertierung der analogen Signale aus dem DataGlove in ein digitales Format, das vom Hostrechner verarbeitet werden kann. Die Kontrolleinheit überwacht außerdem die Source und die Stärke des Lichts, das durch optische Leitungen läuft.

Beim SpaceBall ist ein Ball auf einer Unterlage mit zahlreichen Kontrollknöpfen befestigt. Um die virtuellen Objekte zu bewegen, kann der Benutzer den Ball herumdrehen. Er kann die Kontrollknöpfe (am Ball und auf der Unterlage) drücken, um verschiedene Operationsmodi zu selektieren. Sechs Infrarot-LEDs, die die sechs Freiheitsgrade widerspiegeln, werden an einer Plastiksäule innerhalb des hohlen Balls befestigt. Auch innerhalb des Balls befinden sich infrarote Photosensoren, die die Richtung des Lichts (von LEDs) verfolgen können.

Die SpaceMouse der Firma Virtual Reality Technologies (siehe Abbildung 20), die uns freundlicherweise kostenlos für unseren Vortrag zur Verfügung gestellt wurde, unterstützt alle sechs Freiheitsgrade. Sie steht, wie viele heute üblichen 6D-Mäuse, fest auf dem Tisch und muß nicht mehr, wie z.B. die Maus von Logitech in der Luft herumbalanciert werden. Bei der Handhabung ist die SpaceMouse recht empfindlich, bei den ersten Eingabeversuchen überschlägt man sich leicht und kommt auch nicht immer dort hin, wohin man gerne möchte. Doch nach einiger Einarbeitungszeit und mit Hilfe der Superscape Visualizer-Software, sind die Erfolgserlebnisse doch recht gut. Als Hardware-Grundlage hat die SpaceMouse Leuchtdioden, um die Dreh- und Axialbewegungen zu erfassen. Der Preis für die SpaceMouse liegt momentan bei etwa 1500 DM.

Stellt Euch vor, ihr müßtet mit einem Schiff von Hamburg nach New York fahren, habt aber keinen Kompaß (geschweige denn die Möglichkeiten der Satellitennavigation) und der Himmel ist ständig bedeckt.

Ähnlich würde es dem Computer ergehen, wenn er eine neue Szene berechnen soll und weder weiß, wo Du Dich befindest, noch wohin Du schaust. Deshalb ist ein Tracking-System, daß ständig Deine Position im Raum ermittelt, unabdingbar. Neben der absoluten Kopfposition ist noch die Orientierung wichtig, d.h. in welche Richtung Du gerade blickst und wo sich Deine Hand befindet.

Es gibt vier verschiedene Tracking-Technologien:

Zu den optischen Systemen gehören auch Videokameras mit anschließender Bildauswertung (wie bei Kruegers VIDEOPLACE/DESK). Diese Methode liefert aber die ungenauesten Resultate.

Eins der größten Probleme, die die VR-Systeme haben, ist die fehlende taktile Rückmeldung. Wenn der Cybernaut eine Kaffeekanne hochhebt, kann er sie mit seiner physikalischen Hand nicht fühlen, schlimmer noch, er kann durch sie hindurchgreifen. Die Forschungen befinden sich hier erst noch in den Anfängen und es wird noch lange dauern, bis die virtuellen Äquivalente des Schlagens, Drückens, Streichelns, Küssens, Pieksens, Kratzens, Scheuerns, Leckens, Hauchens usw. perfekt simuliert werden können.

Zwei Probleme sind zu unterscheiden:

In diese Richtung geht zum einen der Touchmaster von Exos. Hierbei handelt es sich um einen gewöhnlichen Datenhandschuh, zusätzlich sind aber 30 Taschen eingearbeitet, die mit unterschiedlichen Luftdrücken gefüllt werden können.

Ein anderes Beispiel ist der Joystick von Magaret Minsky, der am MIT (Massachusetts Institute of Technology) entwickelt wurde. Mit ihm kann man durch virtuelles Eiswasser rühren oder über Sandpapier kratzen.

Etwas über Virtual Reality zu erzählen, ohne selbst mal im Cyberspace gewesen zu sein, das schien uns nicht so das Wahre. Also begaben wir uns zu einem Bummel über die Reeperbahn. Dies war jedoch nicht von Erfolg gekrönt, denn in Sachen VR ist Hamburg wohl noch tiefste Provinz: ,,Virtual Reality? Ist das nicht sowas mit 3D? Nein, das haben wir nicht.``

Also fuhren wir auf gut Glück nach Berlin, vielleicht hatte die Hauptstadt ja mehr zu bieten. Und in der Tat, als wir in der Tourist-Information nachfragten, bekamen wir sofort die Adresse des Virtuality Cafés nahe dem Adenauerplatz.

Als wir jedoch gegen 12 Uhr dort ankamen, war das Café mit Gittern verschlossen, ein Schild mit den Öffnungszeiten nicht zu finden. So wollten wir schon leicht frustriert den Rückweg antreten, als uns doch noch geöffnet wurde. Der Besitzer des Cafés steckte seinen Kopf zur Tür heraus und fragte uns, ob wir von weit her kommen würden. Wir erzählten, daß wir aus Hamburg kommen und uns auf einen VR-Vortrag vorbereiten würden. Darufhin wurde uns bereitwillig aufgemacht und auch noch eine ausführliche Einführung in die VR-Geräte gegeben.

|

| Abbildung 21: Birgit ist in die Billiardsimulation vertieft. Im Hintergrund sind die Stand-Up-Geräte zu sehen. |

Das Café verfügt über vier (zwei mal zwei) Stand-Up und drei Sitzgeräte. Insgesamt probierten wir fünf verschiedene Spiele aus, wobei vier davon zu zweit gespielt werden. Zuerst probierten wir ein Alien-Abschieß-Ballerspiel in den Sitzgeräten aus. Wir hatten aber beide keine Ahnung, wie das Spiel funktionieren sollte. Das zweite Spiel, Dactyl Nightmare, lief wesentlich besser. Wir standen nun in den Stehgeräten und hielten jeder einen frei beweglichen Joystick in der Hand. Ziel dieses Plattformspiels war es, den Gegenspieler zu finden (und dann zu erschießen). Interessant war noch die Billiard-Simulation in einem Prototyp von Kaiser Electro-Optics. Hier war der Spieler die weiße Billiardkugel und spielte aus deren Perspective. Besonders angenehm war bei diesem Gerät auch der Datenhelm, der sich wesentlich besser tragen ließ. Dieser Helm wird mit Hilfe von zwei überkreuzten Bändern locker auf den Kopf gesetzt und muß nicht, so wie bei den anderen Geräten, mit einer Art Schraube am Kopf festgezogen werden. Ein weiterer Vorteil ist für Brillenträger gegeben, denn bei diesen Geräten kann die Brille aufbehalten werden, während die anderen dafür keinen Platz lassen (die Sehschärfe kann zwar an der Seite des Helmes eingestellt werden, ist aber lange nicht so genau wie die eigene Brille).

Wer nun selbst einmal spielen möchte, der muß mit 7 DM pro Spiel rechnen. Bei einer Zehnerkarte reduziert sich der Preis auf 5 DM. Ein Spiel dauert im Durchschnitt drei bis viereinhalb Minuten. Die Adresse des Virtuality Cafés ist im Anhang zu finden.

Eine Untersuchung an der Universität Edinburg hat ergeben, daß zwölf von zwanzig Testpersonen nach einer zehnminütigen Fahrradtour durch den Cyberspace über Übelkeit, Kopfschmerzen und Schleier vor den Augen klagten.

Es wird vermutet, daß die Ursachen hierfür darin liegen, daß die verschiedenen Sinnesempfindungen nicht exakt übereinstimmen (also ganz ähnliche Phänomene wie bei der Seekrankheit auftreten). Beispielsweise entsteht eine merkliche Zeitverzögerung zwischen der Kopfbewegung und der Darstellung der neu zu berechnenden Szene (je nach System einige oder mehrere Zehntelsekunden; der Mensch kann noch eine Latenzzeit von 50 Millisekunden wahrnehmen).

Ein Forschungsteam des britischen Verteidigungsministeriums ist gar zu dem Schluß gekommen, daß schwerwiegende Augenschäden nicht auszuschließen seien.

Inwieweit VR zu einer sozialen Abschottung oder Sucht (die Fluchtwelt ist auf Knopfdruck dar) führen kann, ist noch gänzlich ungeklärt.

Ein Problem werden auch die künftigen Billig-HMDs der Spielekonsolen-Hersteller sein, denn das Tiefenempfinden (vgl. Abschnitt 2.1) beruht auch auf Erfahrung. Da davon auszugehen ist, daß diese Head-Mounted-Displays aus Kostengründen monoskopisch sein werden, wird in [Pos95] ein Verlust der 3D-Sehfähigkeit bei Kindern befürchtet, die die Zielgruppe der Hersteller bilden.

Karstadt AG

Mönckebergstraße 16

20095 Hamburg

Virtuality Café

Lewishamstraße 1

10629 Berlin

Virtual Reality Technologies GmbH

Am Gewerbepark 1

64823 Groß-Umstadt